2025有没有比较好的网页整站下载工具

整站下载工具

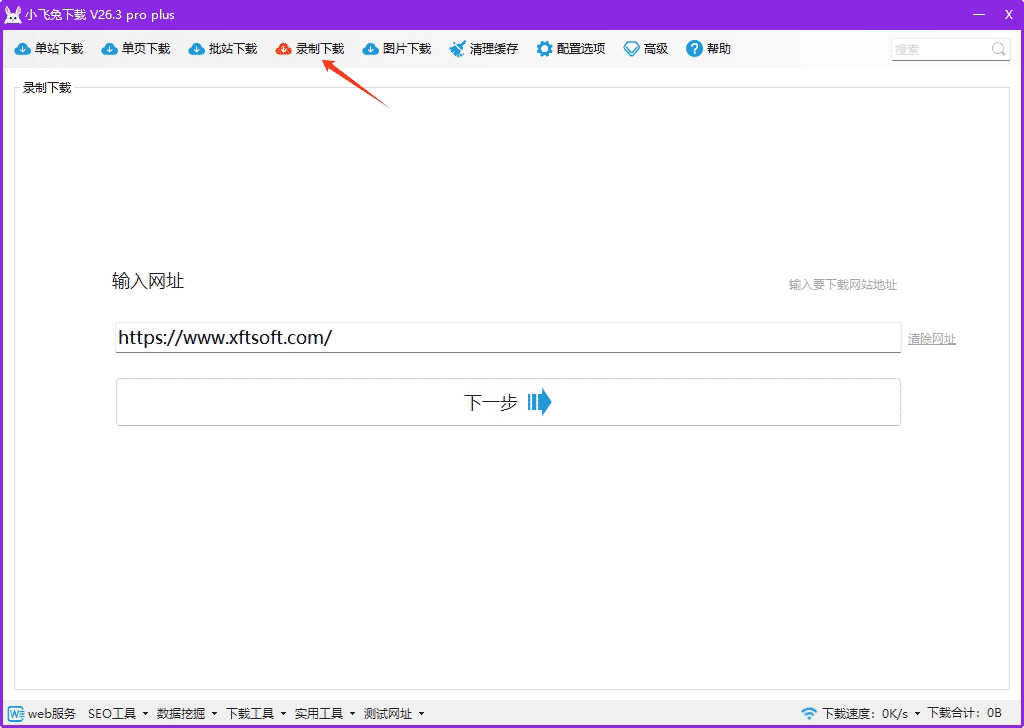

小飞兔

小飞兔是一款功能强大的网页整站下载工具,界面直观易用。用户只需输入目标网站的 URL,工具将自动下载该网站的所有页面、图像、样式表等资源,并将其保存到本地文件夹中。小飞兔还支持深度抓取,确保下载内容的完整性。此外,多线程下载和断点续传功能显著提升了下载效率,使用户能够轻松地创建网站的离线副本以供浏览。

主要特点

- 智能识别 JavaScript 文件中的链接

- 通过录制功能下载基于 Vue、后台系统或 AJAX 异步加载的网站

- 支持 HTTP/2 协议下载

- 强大的自定义配置能力(超50个配置选项),灵活应对各种网站

- 本地测试支持HTTPS服务

功能说明

- 整站下载:下载指定 URL 对应网站的所有页面及资源,适合整个网站的内容抓取。

- 单页下载:仅下载输入的特定 URL 页面。

- 批站下载:批量下载多个站点的内容,适合同时处理多个网站。

- 录制下载:针对无法通过常规方式抓取的网站,内置浏览器录制功能允许抓取后台系统、AJAX 动态加载或 Vue 渲染的页面内容,js动效保持一致,生成模拟的ajax请求。

(独家创新、自主研发) - 静态下载:对使用异步加载(如 Ajax)、模块化加载,以及前端框架(如 Angular、React、Vue.js)动态渲染生成的页面内容进行静态化处理。其核心是将动态生成的视图代码(包括 HTML 和 CSS)快照提取并转换为纯静态页面文件,同时移除 JavaScript 动效和交互逻辑,生成无需依赖前端动态渲染的静态 HTML 页面。

详情参考官网文档:https://www.xftsoft.com/doc/views/doc/静态下载.html#功能对比

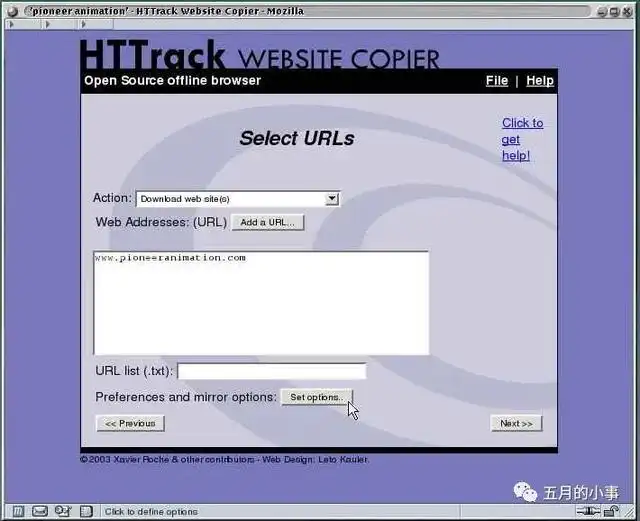

HTTrack Website Copier

- HTTrack Website Copier是一款开源的网页整站下载工具,允许用户将整个网站保存到本地。它支持Windows、Linux和macOS系统,并提供了简单易用的图形用户界面。用户只需输入目标网站的URL,HTTrack会自动下载网站的所有页面、图片、样式表和其他相关文件。

- 该工具还具有强大的配置选项,用户可以选择深度抓取、排除特定文件类型,以及设置下载速度限制等。HTTrack生成的本地副本能够在离线状态下浏览,非常适用于需要在没有网络连接时查看网站内容的情况。

Wget

- Wget是一款命令行工具,用于下载文件和整个网站。它支持多平台,包括Windows、Linux和macOS。Wget的强大之处在于其灵活性和可配置性,用户可以通过命令行参数实现各种下载需求。

- Wget可以递归地下载整个网站,同时支持断点续传和后台下载。它还能够处理网站链接的转换,确保本地保存的页面仍然具有可点击的链接。虽然Wget需要在命令行中使用,但其功能强大,适用于对自定义下载需求有较高控制的用户。

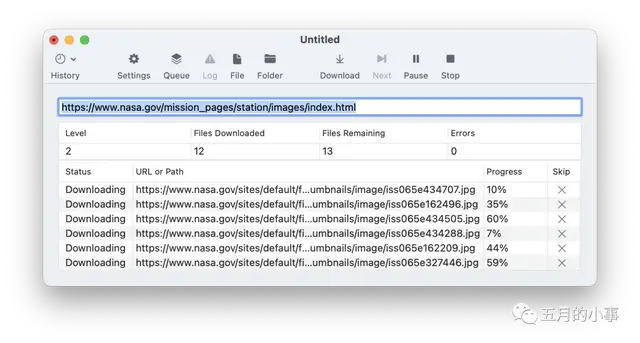

SiteSucker

- SiteSucker是一款专为 macOS 设计的网页下载工具,具有直观的用户界面。用户只需输入目标网站的URL,SiteSucker将自动下载网站的所有页面、图像、样式表等,并保存在本地文件夹中。该工具还支持深度抓取,确保下载的内容完整。

- SiteSucker的优点之一是其简单易用的界面,适合不熟悉命令行操作的用户。此外,它还支持对下载任务的调度,使用户能够在合适的时间执行网站下载操作。

Teleport Pro

- Teleport Pro是一款Windows平台上的专业网页下载工具,旨在提供高度可配置的网站抓取功能。用户可以通过输入目标网站的URL并设置抓取规则,来定制下载任务。Teleport Pro支持深度抓取,确保下载的内容包含所有链接的页面。

- 该工具还提供了强大的筛选和排除功能,使用户能够精确控制下载的内容。Teleport Pro的多线程下载能力和断点续传功能提高了下载效率,适用于需要对网站进行深入研究或备份的用户。

ScrapBook

- ScrapBook是一款基于浏览器的网页整站下载插件,适用于 Firefox 浏览器。用户可以通过在浏览器中添加该插件,轻松保存整个网站或特定页面的副本。ScrapBook提供了简单直观的操作界面,用户可以选择保存的范围、深度和是否下载外部资源等选项。

- 该插件支持离线浏览保存的页面,并具有搜索、标签等组织功能。ScrapBook不仅适用于整站下载,还可用于创建网页快照、收集资料等场景。

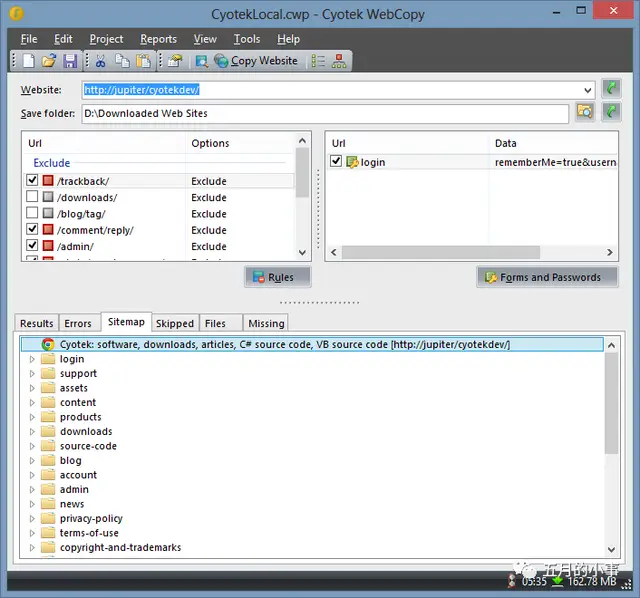

WebCopy

- WebCopy是一款由微软提供的免费网页下载工具,适用于 Windows 操作系统。它具有友好的用户界面,使用户能够轻松地复制和下载整个网站。WebCopy支持深度抓取,可以下载网站内的所有链接页面,同时还能处理动态网页。

- 该工具具有灵活的配置选项,用户可以设置抓取规则、排除特定文件类型等。WebCopy生成的本地副本可用于离线浏览,是对于需要保存网站快照或进行离线研究的用户的理想选择。

常见问答:

问:有哪些常用的网页整站下载工具?

答:一些常用的网页整站下载工具包括HTTrack、Wget和SiteSucker(仅限Mac)。HTTrack是免费且开源的工具,支持将整个网站下载到本地,包括HTML、图像、样式表等。Wget是一个命令行工具,可以递归下载整个网站,并支持断点续传和多种协议。SiteSucker是Mac平台上的工具,可以轻松下载整个网站,支持自定义配置。

问:网页整站下载工具的主要用途是什么?

答:网页整站下载工具主要用于离线浏览、备份和网站迁移。用户可以将整个网站下载到本地,以便在没有网络连接的情况下进行浏览。同时,工具也可用于创建网站的备份,确保在需要时可以还原网站的内容和结构。对于开发者或网站管理员,这些工具也是进行网站迁移的有效手段,可以将网站从一个服务器迁移到另一个服务器,或进行本地开发测试。

问:如何使用网页整站下载工具下载特定网站?

答:使用网页整站下载工具下载特定网站通常涉及以下步骤。首先,选择合适的工具,如HTTrack、Wget或SiteSucker,根据平台和个人偏好。然后,配置工具参数,包括目标网站的URL、保存路径、下载深度等,有些工具还支持设置下载规则和过滤条件。启动下载后,等待工具完成整站下载,过程中可以监控下载进度和日志信息。下载完成后,用户可以在指定的保存路径下查看下载的网站文件,包括HTML、图像和其他资源。在使用这些工具时,需遵守网站的使用规定,尊重知识产权,不违反法律法规。